quinta-feira, 9 de dezembro de 2010

O poder dos Hackers

segunda-feira, 6 de dezembro de 2010

O fim de uma era.

sexta-feira, 3 de dezembro de 2010

Hackers: Maratona promete mexer com grandes mentes.

Ser competitivo influência e alavanca a carreira em TI.

sábado, 9 de outubro de 2010

O Computador Quântico, o que o futuro nos reserva?

terça-feira, 28 de setembro de 2010

quarta-feira, 22 de setembro de 2010

Prepare-se o planeta vai virar de cabeça pra baixo.

Parece filme de ficção científica, mas em 2012, uma nuvem eletromagnética chegará ao nosso planeta causando transtornos elétricos.

Você já ouviu falar de nuvem eletromagnética? Pois é amigos, uma tempestade solar gigantesca, irá emitir eletromagnetismo tão poderoso a ponto de explodir grandes transmissores de energia do planeta causando um enorme blecaute.

Mas você sabe como isso funciona?

O Sol tem toda sua energia sendo gerada no núcleo, com temperaturas que alcançam 15 milhões de graus centígrados. Com fusões nucleares, 5 milhões de toneladas de energia são geradas, junto com um magnetismo intenso. São esses enormes campos magnéticos que criam curvas sobre a superfície solar, que são esticadas e distorcidas em todos os sentidos de maneira irregular.

Quando as curvas colidem, um curto-circuito ocorre e faz com que toda a energia seja liberada. O ciclo magnético solar é de 22 anos, com manchas que atingem seu ápice a cada 11 anos. O fenômeno, chamado de "Máximo Solar", permite que aumentem bastante as chances de ocorrer uma tempestade.

As atividades solares acontecem com frequência, mas nós não as sentimos porque a Terra tem um campo magnético que protege o planeta, chamada de Magnetosfera. O problema é que, dependendo da intensidade de uma dessas tempestades, o “escudo” é arrancado e comprimido em grande parte, permitindo que os efeitos possam ser devastadores.

Depois de uma tempestade radioativa causada pela energia solar, o último “ataque” — e também o pior — é uma explosão da CME (emissão de massa coronal), uma nuvem de gás eletrificado de um bilhão de toneladas. O fenômeno leva entre 4 e 7 dias para chegar ao planeta e não é possível medir sua força.

Quais as consequências de uma forte tempestade solar

Uma tempestade solar leva 8 minutos para chegar à Terra, mas já no início acarreta um carregamento eletromagnético sobre o planeta. Isso faz com que qualquer coisa em órbita corra perigo. Satélites, por exemplo, despencam de volta ao solo, enquanto que aviões perdem as comunicações por rádio.

Em seguida, uma tempestade radioativa atinge o planeta e provoca estragos enormes, pois traz consigo prótons de alta energia capazes de detonar equipamentos eletrônicos. O que e quem estiver no solo é protegido pela força da atmosfera. Porém, o maior problema fica para os astronautas que estiverem fora da atmosfera, pois a radiação intensa é fatal, de maneira que eles têm poucos minutos para conseguirem se proteger.

Os satélites de GPS sofrem sobrecargas e não conseguem mais enviar sinais normais. Sem sistemas de localização, os aviões que estiverem sobrevoando os céus se perdem e seus motores começam a falhar.

Quando a CME finalmente chega ao planeta, seu impacto causa uma sobrecarga extrema em equipamentos elétricos, principalmente nos gigantescos transformadores que distribuem a energia para as cidades. Isso faz com que eles simplesmente explodam e deixem tudo na escuridão total. Seria um blecaute mundial.

O mundo sem energia elétrica

Todo mundo que já presenciou uma breve queda de luz sabe como é terrível ficar horas sem energia elétrica. O problema é que a destruição dos transformadores faria grandes cidades ficarem no escuro por meses e até anos. O motivo é simples: além do alto custo, levaria entre um a dez anos para substituir as redes elétricas danificadas.

Além das comunicações que já teriam sido prejudicadas há algum tempo, sistemas de iluminação das cidades e aquecimento parariam de funcionar. A ausência das redes de sinalizações, como semáforos para carros e trens transformariam a cidade em um caos total e causariam muitos acidentes gravíssimos no início.

Hospitais e outros serviços de emergência, apesar de contarem com geradores de energia, só funcionariam por três dias, de forma que pacientes mais frágeis não seriam capazes de sobreviver. Qualquer equipamento hospitalar dependente da eletricidade não poderia ser utilizado.

Boa parte dos fornecimentos de água e comida seria cortada. O tratamento da água e dos esgotos não poderia funcionar, deixando a população gravemente enferma; doenças como hepatite, disenteria e febre alta se alastrariam.

Isso ainda seria somente o começo, ninguém sabe ao certo medir a proporção de destruição que a tempestade causaria, mas uma coisa é certa, temos que nos preparar para o pior.

sábado, 11 de setembro de 2010

SuperPotência: Qual é o futuro da internet?

Vinte anos depois de sua criação, a rede mundial de computadores, world wide web, criada por um cientista como uma forma simples de dividir informações com colegas, já percorreu um longo caminho.

Foi um milagre acidental que cresceu sem muita orientação de comitês, governos ou corporações.

Foi um milagre acidental que cresceu sem muita orientação de comitês, governos ou corporações.

Mas agora a rede está à beira de outra transformação. Cientistas da Computação estão prevendo o futuro da web e a velocidade em que as coisas vão acontecendo.

Veja abaixo algumas dessas previsões.

Rede mais inteligente

Quer chamemos de rede semântica ou rede de dados interligados, os cientistas acreditam que agora estão construindo uma rede muito mais inteligente.

Ao colocar mais dados online e depois “ensinando” a rede a entendê-los e questioná-los de novas maneiras, eles esperam oferecer aos usuários um recurso muito mais inteligente.

Ao colocar mais dados online e depois “ensinando” a rede a entendê-los e questioná-los de novas maneiras, eles esperam oferecer aos usuários um recurso muito mais inteligente.

“Pense na rede como um grande banco de dados descentralizado contendo de tudo, desde o horário de trens e lugares para comer a sites que informam onde encontrar a melhor oferta. O que a rede vai oferecer é um sistema de buscas muito mais refinado, será uma rede com ‘grãos mais finos’”, disse o pesquisador Nigel Shadbolt, da Universidade de Southampton.

A ideia é que quando alguém fizer uma busca como “próximo trem para Manchester”, em vez de aparecerem várias páginas com informações referentes a trens para Manchester, a rede traga ao usuário uma resposta real. Mas, claro, só se os dados estiverem disponíveis na web.

Shadbolt faz parte de uma campanha liderada pelo criador da rede, Tim Berners-Lee, para convencer o público e órgãos privados a disponibilizar a maior quantidade possível de dados online.

A rede ‘onipresente’

Nós pensamos na rede como algo que acessamos por meio de um browser, usando um teclado.

Mas, de acordo com outra cientista da Universidade de Southampton, Wendy Hall, isto está prestes a mudar: “Vamos conseguir acessar a internet onde quer que estejamos, fazendo o que for, quase sem precisar de nenhum aparelho. Poderemos vê-la por nossos óculos, ou por meio de algum visor que passaríamos a usar”, por exemplo.

A cientista acredita que o browser vai desaparecer e que vamos interagir com a rede por meio de aplicativos, como muita gente já faz com os chamados smartphones.

Objetos nas nuvens

E não apenas as pessoas estarão online.

Mais e mais objetos - como carros, monitores cardíacos e sensores em nossas casas - estarão conectados à internet, contribuindo para um crescente fluxo de dados.

Mais e mais objetos - como carros, monitores cardíacos e sensores em nossas casas - estarão conectados à internet, contribuindo para um crescente fluxo de dados.

Onde serão armazenados todos esses dados? Na “nuvem”, claro, ou, em outras palavras, nos enormes bancos de dados sendo construídos pelos super poderes da web, como a Google e a Microsoft.

“Em certo sentido, a rede está se tornando um grande computador”, disse Andrew Herbert, à frente do laboratório da Microsoft em Cambridge.

A rede de celulares

Está claro que o futuro da rede está nos celulares – e para a maioria dos bilhões de pessoas que se juntarem a ela nos próximos anos, sua primeira experiência de acesso à web será por telefone celular.

Um dos grandes pensadores da indústria de celulares, Benoit Schillings, da empresa Myriad Software, afirma que isso vai nos tornar ainda mais dependentes da rede.

Um dos grandes pensadores da indústria de celulares, Benoit Schillings, da empresa Myriad Software, afirma que isso vai nos tornar ainda mais dependentes da rede.

“Nós partimos do princípio de que é algo que temos conosco o tempo todo. Então quando você perde o seu telefone, se torna um desastre – é agora uma parte essencial de como seres humanos funcionam.”

Mas Schillings afirma que as limitações de uma rede de celulares, em comparação com os dados sendo baixados por uma linha fixa, significa que pesquisas em áreas como compressão de informação se tornam ainda mais vitais.

Uma rede sustentável?

Então, como podemos garantir que esta rede inteligente, móvel e penetrante possa continuar crescendo sem engolir o planeta?

O pesquisador Andy Hopper, da Universidade de Cambridge, lidera um programa chamado Computação pelo Futuro do Planeta.

O pesquisador Andy Hopper, da Universidade de Cambridge, lidera um programa chamado Computação pelo Futuro do Planeta.

Ele está otimista com o que a rede pode fazer.

“É um marca-passo para o planeta, uma parte indispensável para a nossa civilização”, diz ele.

Mas ele agora está procurando meios para que tecnologias de computação possam ser usadas para controlar ou reduzir suas pegadas de carbono.

Um de seus alunos, por exemplo, está tentando criar um monitor pessoal de energia que use a nova “rede de objetos” para juntar todos os tipos de informação de sensores online que monitoram o uso de energia.

Mas, quanto mais a rede crescer, maiores serão as ameaças a sua estabilidade, ou não?

“A piada corrente entre a comunidade de engenheiros é que a internet está sempre à beira do colapso”, afirma Craig Labowitz da Arbor Networks, que monitora o desempenho da rede.

Ele é otimista e acredita que a rede vai continuar “se consertando”, mas afirma que, cada vez mais, isso vai depender das grandes corporações que agora controlam o tráfego.

Nos últimos três anos, afirma Labowitz, a participação da Google no tráfego global da internet aumentou de 1% para 10%.

Quem controla?

O que nos traz à questão crucial: quem controla o futuro da rede? Até agora ela vem crescendo de acordo com os princípios de abertura e parâmetros acertados mutuamente – mas alguns temem o surgimento de uma rede corporativa onde a inovação e a liberdade de expressão serão prejudicados.

“Não há garantias de que ela continuará evoluindo da maneira como é hoje – aberta, gratuita e com parâmetros universais”, afirma Wendy Hall.

“Não há garantias de que ela continuará evoluindo da maneira como é hoje – aberta, gratuita e com parâmetros universais”, afirma Wendy Hall.

“Se você perder isso, ou se os parâmetros forem superados por preocupações corporativas, então a rede vai mudar dramaticamente”, conclui.

terça-feira, 7 de setembro de 2010

Conheça o dia a dia dos profissionais de segurança da informação.

Responsabilidade vai muito além de configurar e manter sistemas. Atuação passa por inteligência, educação e desenvolvimento de produtos.

É responsabilidade de um profissional de segurança da informação a manutenção de sistemas, a elaboração de políticas, planos e instalação de produtos e equipamentos que protegem os bens virtuais e os dados de uma empresa. Mas há profissionais que atuam na área e que trabalham com inteligência e educação em segurança, ou ainda com desenvolvimento de produtos, análise de códigos maliciosos e outras áreas. A coluna Segurança para o PC conversou com três profissionais para saber como é o dia a dia de trabalho na área.

Se você tem alguma dúvida sobre segurança da informação (antivírus, invasões, cibercrime, roubo de dados, etc), vá até o fim da reportagem e utilize a seção de comentários. A coluna responde perguntas deixadas por leitores todas as quartas-feiras.

Fabio Assolini (analista de vírus), recebe arquivos para determinar se são vírus brasileiros.

Fabio Assolini (analista de vírus), recebe arquivos para determinar se são vírus brasileiros.

Para que um vírus seja detectado por um software de proteção, ele precisa ser analisado e reconhecido como um código malicioso. O trabalho de Fabio Assolini é exatamente esse. Trabalhando no Brasil para a equipe global de analistas da empresa russa Kaspersky Lab, ele precisa analisar ataques de origem nacional.

“A primeira ação a ser feita é verificar a origem da praga. Como meu trabalho é focado somente em pragas brasileiras, essa filtragem é importante”, explica Assolini. O analista precisa usar várias técnicas, algumas bem simples, como a análise do endereço em que o vírus está, até outras mais sofisticadas, como a identificação da estrutura e da linguagem de programação usada para o código malicioso.

Assolini gosta de ter conhecimento a respeito de cada ação de uma praga virtual, mas os programadores de vírus não facilitam esse trabalho. “Para dificultar esse trabalho de análise, alguns criadores de vírus usam alguns truques, como empacotadores para criptografar o código do vírus, antiemuladores e antivirtualizadores”, diz. Como a pesquisa da praga digital normalmente envolve a execução do vírus é preciso emular ou “virtualizar” o código. Assim ele fica enjaulado em um laboratório sem conexão com o mundo real. Os vírus tentam detectar esse ambiente, impedindo que a analista proceda sem complicações.

“Desmontar tudo isso é como decifrar uma charada e poder ver o que nem todos podem ver, desvendar algo que estava oculto, criptografado, e sentir-se realizado ao fazê-lo”, afirma Assolini.

O processo não leva muito tempo. Mesmo para as pragas mais complexas, Assolini investe apenas 20 minutos. Nas mais simples, cinco minutos são suficientes. O conhecimento obtido por fazer isso diariamente ajuda. “Entre os criadores de vírus brasileiros há um comportamento comum de reaproveitamento de código, o que torna algumas pragas muito parecidas entre si”, comenta.

O trabalho não se transforma apenas em atualizações para antivírus. Assolini também precisa participar de eventos – para se informar ou para palestrar – e atender a imprensa. Ele também precisa escrever artigos sobre o comportamento das ameaças locais.

“A parte interessante está no fato de ver, no final de um dia de trabalho, seu esforço se converter em proteção para os usuários finais. Não há tarefas entediantes, cada nova análise é uma surpresa, e a cada dia aparecem novos desafios nessa área. A gente sempre tem a percepção que não sabe tudo e que ainda tem muita coisa para aprender, isso espanta o tédio”, finaliza.

Anchises de Paula, pesquisador de inteligência em segurança, precisa criar relatórios e enviar informações de fraudes nacionais aos EUA.

Anchises de Paula, pesquisador de inteligência em segurança, precisa criar relatórios e enviar informações de fraudes nacionais aos EUA.

A área de segurança evolui rapidamente. Suas várias ramificações se expandem e fica difícil encontrar alguém que possa fazer uma leitura do todo e, com isso, entender o que realmente está acontecendo. Esse é o trabalho de Anchises de Paula, pesquisador de inteligência em segurança na iDefense, uma empresa da Verisign.

“É um trabalho diferente do normal, pois nós temos que entender os vários aspectos de segurança em cada país: quais são as principais ameaças, motivações, grupos ativos e, do outro lado da moeda, como as autoridades e empresas reagem e combatem o crime cibernético”, explica Anchises.

Para realizar essa tarefa, o profissional precisa estar sempre atento às novidades da área. “A principal tarefa que eu preciso realizar é acompanhar as notícias e novidades da região, em termos de segurança e ameaças, selecionar os fatos mais importantes e reportar para os EUA, através de algumas ferramentas como, por exemplo, uma base de dados de notícias”. Essa informação também será usada para criar relatórios contendo análises de cenários e ameaças.

Outra parte do trabalho consiste em responder perguntas diretas enviadas por clientes da iDefense. Para isso, Anchises precisa saber quem realiza pesquisas em segurança no Brasil e como funcionam as fraudes que ocorrem no país. Para conseguir isso, a participação em eventos, para manter-se informado e conhecer pessoas, torna-se uma parte fundamental da rotina do profissional.

O que motiva esse trabalho é a busca pelo entendimento completo do complicado mundo da segurança. “A cada dia posso receber uma demanda por algum tipo de informação ou análise de um assunto totalmente novo e inesperado, logo há um componente muito forte de pesquisa e análise. Além disso, há a vantagem de estar acompanhando diariamente as principais novidades no setor de segurança da informação em todo o mundo”, afirma Anchises.

Anderson Ramos, diretor técnico de treinamentos, trabalha com criação de conteúdo educativo e treinamento. Sou una interface (ponte) entre os hackers e quem protege as redes, diz.

Anderson Ramos, diretor técnico de treinamentos, trabalha com criação de conteúdo educativo e treinamento. Sou una interface (ponte) entre os hackers e quem protege as redes, diz.

O que Anderson Ramos aprende não é apenas para si mesmo. Como diretor técnico de uma empresa focada em treinamentos, ele precisa “empacotar” seu conhecimento em cursos, livros e palestras. “Gasto boa parte do tempo analisando o que os grandes cérebros estão produzindo, separando o que é relevante para as empresas”, conta.

“Visito cerca de dez conferências por ano, em países variados, porque não dá mais pra pensar em segurança com foco apenas local”, afirma.

Questionado sobre algo que faz esporadicamente, ele responde: “dormir”. Ramos precisa dar aulas, palestras ou escrever o material que será repassado às equipes de segurança das empresas.

O especialista gosta do seu trabalho porque sente que aproxima dois lados aparentemente opostos do mundo da segurança da informação. “Quase tudo que há de genial em TI foi criado por hackers, no sentido original da palavra. Alguns consomem todo seu tempo procurando falhas, outros se focam na correção. Sem essa dicotomia não haveria Internet nem uma série de outras coisas. O que me motiva é levar conhecimento de um lado para o outro, contribuindo para aproximar esses opostos ao invés de afastá-los”, observa.

O grande desafio dessa área, segundo Ramos, está na educação dos desenvolvedores de software. “Alcançamos um nível de maturidade razoável em algumas áreas, como segurança em redes. Estamos muito distantes de conseguir o mesmo nas aplicações, principalmente na web”. Ele opina que falta uma sensibilização por falta dos gestores, que ainda não percebem a necessidade de dar atenção para essa área.

Em parte o problema existe porque é difícil medir os resultados de projetos que visam educar e treinar os profissionais. “Medir resultados de investimentos em educação no curto prazo é razoavelmente fácil: o cliente sempre lhe diz ao final se gostou ou não. Saber se aquele resultado é duradouro é mais difícil e não depende só de mim”, explica.

Apesar da dificuldade, Ramos sabe como tirar satisfação do seu trabalho. “Fico particularmente feliz ao ver um ex-aluno alcançando seus objetivos através do conhecimento, seja um estagiário ou o diretor de segurança de uma grande corporação. Não há métrica melhor do que o impacto concreto que você deixa por onde passa, por menor que ele seja”, diz.

segunda-feira, 6 de setembro de 2010

Como serão as telas no futuro?

Se prever o dia de amanhã é tarefa impossível, somente especular como ele pode ser já não é tão difícil.

Pensando nas tecnologias hoje disponíveis em telas sensíveis ao toque (e em todas as pesquisas feitas na área), a empresa TAT elaborou um vídeo retratando o dia-a-dia num futuro não tão distante.

O princípio é simples: se hoje as telas capacitivas são comuns nos nossos aparelhos, muito em breve teremos displays maleáveis, duplos, telas embutidas em espelhos ligados via wi-fi ou em mesas, dotadas de holografia e até mesmo com a capacidade de se localizar em relação a outras telas.

Devo lembrá-los que esta tecnologia de telas ultra finas já é realidade e está presente no mercado, como as telas led e a mais recente e flexível o-led onde sua aplicação é viável a diversos tipos de ambiente e formas diferentes.

O chamado “vídeo experiência” mostra a vida de um casal comum em 2014, quando todas essas tecnologias forem acessíveis e super divulgadas.

A TAT é uma empresa sueca de desenvolvimento de software e design para aparelhos portáteis. A companhia já participou da construção de mais de 300 aparelhos em todo o mundo, incluindo dispositivos da SonyEricsson, Motorola, S60, Samsung, Vodafone e Orange.

HP promete colocar novos tipos de mémoria no mercado.

Muita gente conhece os transistores, que são componentes básicos na eletrônica atual. Agora, o memristor (na foto, ampliado por microscópio) pode ser novidade para muita gente, ainda que essa forma de armazenamento de memória seja estudada há alguns anos. A novidade mesmo é a venda dessa tecnologia pela HP.

Muita gente conhece os transistores, que são componentes básicos na eletrônica atual. Agora, o memristor (na foto, ampliado por microscópio) pode ser novidade para muita gente, ainda que essa forma de armazenamento de memória seja estudada há alguns anos. A novidade mesmo é a venda dessa tecnologia pela HP. Para colocar a nova tecnologia no mercado, a HP anunciou uma parceria com a empresa Hynix Semiconducter. A ideia é desenvolver uma nova memória, chamada de ReRAM. Essa memória poderia ser usada em lugar das memórias flash, que seria substituída pelo memristor.

O memristor tem uma arquitetura diferente dos transistores que conhecemos. Em vez de funcionar com a passagem de corrente elétrica de um lado a outro, como numa linha, o memristor entende a corrente elétrica baseado na sua resistência — e não precisa fazer isso em duas dimensões.

Isto torna o memristor um projeto muito significativo, pois cria sistemas com algumas das capacidades de correspondência de padrão a do cérebro humano, como a relação ao ligar e desligar do computador que passaria a ser como o ligar e desligar de uma luz elétrica (instantâneo), o que tornará possível o desenvolvimento de sistemas computacionais mais eficientes em termos energéticos e mais economia na conta elétrica.

Essa possibilidade permite alguns trunfos significativos ao memristor, entre eles tamanho reduzido e alta quantidade de informações por espaço. Os componentes dos transistores ocupam entre 30 e 40 nanômetros. No memristor essa medida cai para 3 nanômetros. Quanto à memória, a HP afirma que em três anos o componente poderá armazenar até 20 GB por centímetro quadrado.

sábado, 4 de setembro de 2010

O telefone como nós conhecemos está nos últimos dias de vida.

A telefonia móvel e a internet provocaram mudanças profundas em nossos meios de comunicação. Em breve, números de telefone e aparelhos fixos podem se tornar coisas do passado!

Quantos números de telefone você sabe de cor? O da sua casa, do seu pai, da sua mãe, do namorado ou da namorada e... Pois é. Cada vez menos decoramos números de telefone. Afinal, quem é que precisa decorar várias sequências de números quando o contato pode ser feito com apenas um clique?

Seja pela internet ou utilizando o celular, armazenamos os números uma vez e nunca mais os visualizamos. Eles deixam de ser números e passam a exibir o nome da pessoa. Você clica no contato e faz a ligação, envia uma mensagem, um email, um arquivo, etc.

Além disso, é possível utilizar videoconferências e chamadas de voz via internet sem gastar por uma ligação, com serviços como Skype. Todas essas mudanças ocorreram em menos de meio século, enquanto o telefone comum existe há mais de um século e seu serviço permanece igual.

Números de telefone vão morrer?

Especialistas afirmam que sim e, os mais otimistas, dão um prazo curtíssimo para que isso aconteça. Não só pelo fato de que não acessamos mais os números, mas por uma unificação de seu serviço com as redes sociais.

Como afirmamos na introdução, hoje é possível contatar uma pessoa com apenas um clique, escolhendo o modo de comunicação. Em nossos computadores, tablets e smartphones podemos reunir todas as informações que a própria pessoa nos fornece.

E essa é uma das grandes questões do número de telefone. Qualquer um tem acesso a ele e pode fazer uma chamada, desejada ou indesejada. Por outro lado, nas redes sociais, você controla quem pode receber suas informações e quais informações são publicadas.

Sem um número que qualquer pessoa possa discar, o acesso é limitado da maneira que você deseja, possibilitando um controle maior sobre suas comunicações. Além disso, o número está ligado ao aparelho e a um determinado lugar.

A portabilidade deu uma nova cara aos números de telefone, fazendo com que ele seja o seu número e não mais o da operadora. 70% dos pedidos de portabilidade são da telefonia móvel, para usuários que querem manter seus números de celular.

Ou seja, não há mais grande preocupação em manter o telefone de sua casa ou empresa, pois o telefone celular cresceu em importância no mercado. Não há como negar a vantagem de ter um telefone sempre com você ao invés de um número fixo.

Comunicação por voz e as redes sociais

Outro aspecto apontado para o fim do telefone comum é a experiência limitada do usuário. Enquanto aparelhos e gadgets oferecem vários meios de comunicação em um lugar só, o telefone é apenas uma forma de comunicação por voz.

Texto, imagens, vídeos e arquivos são ser enviados pela internet, e tudo isso pode ser feito enquanto você conversa – por voz - com um de seus contatos. Isso leva alguns especialistas a afirmar que em breve poderemos ter serviços de voz em sites como Facebook.

Isso faria com que o telefone deixasse de ser um aparelho com uma função específica para se juntar a todas as outras funções que podemos utilizar em nossos computadores e smartphones, como jogos, imagens, grupos de contatos, entre outros.

VoIP

Os serviços de VoIP, que nada mais são do que telefonia via internet, têm crescido consideravelmente. Inicialmente, pensou-se em colocar o telefone no computador, mas melhor do que isso é integrar serviços de voz aos aplicativos de comunicação via internet.

Isso faz com que a comunicação seja mais barata. Além disso, os avanços tecnológicos tem permitido que esse tipo de ligação seja cada vez mais eficiente, sem grandes lags no envio de som e imagem.

Até mesmo aplicativos para smartphones já possuem funções de chamada de voz. Com as conexões cada vez mais rápidas e baratas, a substituição do telefone pelo VoIP é algo que já começa a acontecer.

E o futuro?

O avanço da tecnologia no mundo atual globalizado faz com que as mudanças ocorram aceleradamente no mundo atual. O celular apareceu só no final do século XX e em pouco tempo de vida, sua evolução já foi bem maior do que a do telefone fixo.

E continuamos mudando. Até pouco tempo atrás, videoconferências eram vistas só em desenho animado, e hoje são algo real. Acessamos informações do mundo com pequenos aparelhos que, daqui um ou dois anos já estarão ultrapassados.

Sendo assim, não podemos afirmar que os números de telefone vão acabar ou que a telefonia fixa encontrará seu fim. Mas podemos, com toda certeza, afirmar que muito em breve teremos novas formas de comunicação, fazendo com que a telefonia fixa vire, realmente, coisa do passado.

terça-feira, 24 de agosto de 2010

Novas patentes da Apple revelam um iMac Touch

Com a descoberta de algumas patentes da maçã, fica evidente que a empresa tem planos de trazer a tela de toque para aparelhos mais robustos.

Dispositivos com touchscreen (tela de toque) deixaram de ser um diferencial para serem praticamente um recurso básico nos eletrônicos de hoje. Isso fica ainda mais evidente agora, que foram encontradas patentes recentes registradas pela Apple do que seria um "iMac Touch".

O aparelho consiste de uma tela em uma base relativamente flexível, que pode ser facilmente ajustada para que a ela fique deitada. Isso sem removê-la da base, o que cria uma espécie de tablet confortável. O aparelho seria equipado também com acelerômetros para detectar qual o modo atual.

Ou seja, quando estiver de pé, o teclado e o mouse funcionam normalmente e o sistema é o Mac OS X. Quando a tela está deitada, o toque passa a ser essencial e o sistema operacional passa a ser algo mais específico para um tablet, como o iOS do iPhone e iPad.

Apesar de ser uma boa ideia utilizar o toque para controlar o Snow Leopard, por exemplo, trata-se de um sistema não otimizado para isso, o que tornaria complicado e trabalhoso desempenhar diversas tarefas diferentes. Sendo assim, é possível que a Apple utilize ou o próprio iOS ou um híbrido do sistema do Mac como o dos portáteis.

Um aparelho que incorpora dois sistemas em um único local não é uma má ideia, já que, atualmente, ficamos divididos entre múltiplos dispositivos para executar, muitas vezes, as mesmas funções. Assim, temos aplicativos de emails, fotos e calendários em quatro aparelhos diferentes, por exemplo. Com isso, é comum que as informações sejam diferentes em cada um deles, o que cria uma desorganização para o usuário, por mais que ele faça uso da sincronização.

Ao juntar isso tudo com a "necessidade" atual de dispositivos com tela de toque, um iMac Touch parece uma boa pedida, principalmente para os fãs de produtos da maçã. Vale lembrar que, por se tratar de uma patente, é somente um conceito, não propriamente um produto a ser lançado. Só resta esperar.

segunda-feira, 9 de agosto de 2010

Descubra quais são os antivírus mais confiáveis do planeta.

Seu antivírus passa no teste? Uma das maiores centrais de testes de segurança do mundo divulgou os resultados de suas últimas análises.

A cada período de quatro meses, o site norte-americano AV-Comparatives publica um relatório detalhado sobre os mais populares antivírus do mundo. Este relatório mostra quais são os programas de proteção mais recomendados, de acordo com os testes superdetalhados efetuados pelos profissionais especializados no assunto.

Os programas testados são alguns dos mais utilizados em todo o mundo, inclusive alguns que são muito adorados pelos usuários do Tecmosfera. São eles: Avast Free 5.0, AVG 9.0; Avira, Premium 9.0, BitDefender 2010, eScan 10, ESET NOD32 4.0, F-Secure 2010, G Data 2010, K7 Total Security 10, Kaspersky 2010, KingSoft 2010, McAfee Plus 2010, Microsoft Security Essentials, Norman 7.3, Panda Pro 2010, PC Tools Spyware Doctor 7.0, Sophos 9, Norton 2010, Trend Micro 2010 e TrustPort 2010.

Os testes feitos pelo AV-Comparatives analisam as capacidades de proatividade dos antivírus. Ou seja, analisam o quão confiáveis são os programas em relação ao número de atualizações disponibilizadas, o tempo decorrido entre o surgimento de uma nova ameaça virtual e a publicação de uma vacina e o número de ameaças encontradas em um computador preparado com as mais diversas pragas.

Há vários tipos de praga utilizados pelo AV-Comparatives: são worms (malware autorreplicante que infesta as máquinas e deleta informações importantes), backdoors (falha de segurança que abre portas para invasões de outros arquivos maliciosos), trojans (arquivos que permitem a invasão de outros usuários) e também outros tipos de malwar, aglutinados em um mesmo resultado.

Outro fator importante para a análise era a detecção de falsos-positivos, ou seja, arquivos que são identificados como maliciosos, mas que na verdade não o são. De acordo com a quantidade dessas detecções, os antivírus eram rebaixados para outras categorias.

Ao contrário do que muitos esperavam, quatro dos antivírus mais utilizados pelo público brasileiro ficaram fora do topo do pódio. Os gratuitos AVG e Avast e os pagos Norton e Panda conseguiram apenas o segundo selo do AV-Comparatives (Advanced), ficando atrás de outros como Kaspersky, Avira, Microsoft e NOD32, que conseguiram o principal selo (Advanced+).

É importante ressaltar que outros antivírus populares, como o McAfee, Trend Micro e PC Tools conseguiram apenas o selo Standard (Antivírus padrão). O único software que ficou fora dos selos indicativos é o Kingsoft, que conseguiu apenas a marca de “testado”.

Agora que você sabe dos resultados deste teste feito pela maior central de comparação de antivírus do planeta, conte para o tecmosfera qual será a sua atitude em relação ao antivírus que utiliza. Continuará a utilizar o mesmo ou mudará para um mais confiável?

Eletroeletrônicos e informática puxarão consumo pela internet

Intenção de compras pela rede chegou a 87%, segundo o Provar.

Cartão de crédito é forma de pagamento preferida dos consumidores.

O índice que mede a intenção de compras pela internet apresentou alta no terceiro trimestre de 2010, em relação ao segundo trimestre deste ano, passando de 80,7% para 87,0%, de acordo com pesquisa do Programa de Administração do Varejo (Provar).

O item Eletroeletrônicos liderou a intenção de compras no terceiro trimestre, com 34,2%. Em segundo lugar, Equipamentos de Informática, com 28,8% das intenções, seguido de e CDs, DVDs, Livros e Revistas , com 23,7%.

A intenção do compras do terceiro trimestre em relação ao do segundo trimestre deste ano se mostra mais favorável a produtos de lazer. O número de pessoas dispostas a usar a internet para comprar itens de Viagens e Turismo teve expansão, com 16,8% das intenções de consumo. Em segundo lugar, Produtos para Casa, com 14,6%, seguido de Eletroeletrônicos, com 13,4%.

De acordo com a pesquisa, nove das dez categorias analisadas apresentaram aumento na intenção de compras na internet para o terceiro trimestre em relação ao segundo trimestre deste ano. Apenas o item "Cosméticos, Perfumaria e Saúde" não apresentou variação positiva. Já em relação ao mesmo período de 2009, apenas três categorias demonstram aumento de intenção de compra.

A pesquisa indicou ainda que o cartão de crédito é a forma de pagamento mais utilizada sendo a preferida de mais de 60% dos consumidores em todos os segmentos.

Segundo Claudio Felisoni de Angelo, coordenador geral do Provar, esse resultado aponta que a confiança do consumidor na economia é o principal fator para o incremento da intenção de compras. Felisoni atribui o aumento do rendimento médio real do trabalhador nos últimos anos e a estabilidade econômica ao aumento da intenção de consumo.

A Pesquisa Trimestral de Intenção de Compra na Internet, realizada pelo Programa de Administração do Varejo (Provar), em parceria com a Felisoni Consultores Associados e a e-bit, empresa especializada em informações do comércio eletrônico, analisa a intenção de compra e de gasto em relação a dez categorias de produtos (Linha Branca; Eletroeletrônicos; Telefonia e Celulares; Informática; Produtos para Casa; CDs, DVDs, Livros e Revistas; Cosméticos, Perfumaria e Saúde; Brinquedos; Utilidades Domésticas; Viagens e Turismo) e avalia a utilização de crédito nas compras.

Memória com nova tecnologia envolvendo elétrons é criada nos EUA

Inovação permite maior armazenamento de dados em espaço menor.

Pesquisadores da Universidade estadual de Ohio, nos Estados Unidos, conseguiram construir a primeira memória de computador baseada no spin eletrônico para ler e transmitir informação. O nome do material é vanádio tetracianoetileno, é o primeiro magneto à base de polímeros que funciona acima da temperatura ambiente.

Spin é um termo utilizado para expressar a capacidade que partículas subatômicas têm de apresentar movimento de rotação quando submetidas a um campo magnético. Não significa que elas girem no espaço, já que o spin não diz respeito às três dimensões espaciais conhecidas.

A nova tecnologia, uma alternativa à microeletrônica tradicional, permite explorar as propriedades magnéticas de materiais muito finos. Os resultados do trabalho coordenado por Arthur Epstein são tema da revista Nature Materials em agosto.

Spintrônica

Compostos eletrônicos comuns armazenam informação com uso do sistema binário, apenas utilizando 0 e 1, de acordo com a presença ou não do elétron em uma parte de determinado material.

Cientistas descobriram durante o século XX que elétrons podem ser polarizados em direções específicas, distintas das dimensões do cotidiano. O trabalho com essa propriedade dos elétrons, voltado para o armazenamento de informação, chama-se spintrônica.

"A spintrônica é vista, normalmente, como um caminho para obter mais informação de um elétron, mas é, na verdade, a próxima geração de eletrônicos", afirma Epstein. "Muitos dos problemas enfrentados por computadores hoje poderiam ser resolvidos por meio da spintrônica."

Alterar o spin de um elétron requer pouco energia, segundo o especialista. Com a menor geração de calor, dispositivos à base de spintrônica poderiam funcionar com bateria menores. Caso fabricados com plástico, eles também seriam leves e flexíveis.

No caso da experiência da Universidade de Ohio, o material utilizado é classificado por Epstein como um híbrido entre um semicondutor feito com material orgânico e outro à base de polímero magnético, conhecido como imã plástico.

"A nossa conquista foi usar um semicondutor à base de polímero magnético como um polarizador de spin", diz Epstein. "Isso significa que nós conseguimos salvar informação com apenas um pequeno campo magnético e um detector de spin, para que pudéssemos ler os dados."

4G deve chegar ao Brasil em 2013.

Anatel vai transferir frequências de TV por assinatura para operadores de telefonia.

A direção da Agência Nacional de Telecomunicações (Anatel) aprovou na semana passada alterações no regulamento sobre as condições de uso de radiofrequências nas faixas de 2.170 MHz a 2.182 MHz e de 2.500 MHz a 2.690 MHz.

Atualmente, essas faixas são utilizadas para a prestação de serviços de comunicação multimídia e TV por assinatura via MMDS (Serviço de Distribuição de Sinais Multiponto Multicanais).

Com as mudanças, as faixas também poderão ser usadas também para telefonia fixa e móvel.

De acordo com o cronograma estabelecido pelo conselho diretor da Anatel, a assinatura dos termos de autorização devem ocorrer até 31 de dezembro de 2012, após realização de processo licitatório.

Do total de 190 MHz disponível na faixa de 2,5 GHz, as operadoras de celular devem ficar com 140 MHz. A proposta é que a partir de 2013, um ano antes da Copa do Mundo, o país já ofereça a tecnologia de acesso móvel 4G.

O conselheiro da Anatel, João Rezende, ressaltou que o número de assinantes de TV paga por MMDs é de apenas 400 mil assinantes, em 311 municípios, enquanto a evolução crescente da telefonia celular responde por uma base de 180 milhões de usuários.

Em compensação, as empresas de TV por assinatura também poderão ofertar banda larga móvel.

O início da análise dos editais devem começar em novembro. Até fevereiro, a minuta do projeto deve estar disponível para consulta pública. A publicação deve ficar para setembro de 2011. A homologação das empresas vencedoras deve acontecer até o fim de 2012.

O 4G é uma evolução dos padrões de telefonia atual. As tecnologias que são mais exploradas na indústria são WiMax e LTE (Long Term Evolution).

domingo, 8 de agosto de 2010

Como melhorar o sinal da rede sem fio mudando o canal Wi-Fi do roteador.

Em poucos minutos você pode configurar seu roteador para obter mais velocidade e estabilidade durante a transmissão massiva de dados através da rede wireless.

Com a introdução das redes sem fio todos tiveram muitos benefícios, mas as dores de cabeça aumentaram significativamente. Um dos tantos problemas é a configuração dos roteadores, aparelhos que possuem uma série de opções que afetam diretamente a usabilidade da rede.

Contudo, nem sempre a configuração é o maior problema, sendo que a instalação física acaba atrapalhando seriamente o sinal da rede. Enfim, são muitas complicações e poucas soluções, mas o Tecmosfera procura sempre por novidades e truques para ajudar você. O tutorial de hoje visa auxiliar você a aumentar a qualidade do sinal da sua rede wireless e também fornecer algumas dicas para uma instalação e utilização apropriada do mundo sem fio.

Entendendo o problema

Talvez você não seja muito entendido das telecomunicações e possivelmente você nem faça ideia de como funciona um roteador sem fio. Nós explicamos: basicamente o roteador é como um transmissor de sinal, o qual utiliza ondas para propagar dados e conectar diversos computadores.

Como ele faz isso? Simples. O roteador possui uma série de dispositivos internos que codificam os dados e colocam todos numa faixa de transmissão (chamada de canal). É como você imaginar os canais de televisão, ou seja, o roteador envia o sinal de rede e de internet (assim como as emissoras de TV) em um canal específico para que o computador que esteja sintonizado no mesmo canal receba os dados.

Por que mudar de canal? Pelo mesmo motivo que você deve mudar de canal na televisão – ou quase o mesmo motivo. Normalmente mudamos de canal para visualizar outros programas na TV, porém algumas vezes nos forçamos a mudar porque a qualidade do canal é horrível. No caso das redes wireless o que força a mudança de canal geralmente é a qualidade que está muito baixa.

Geralmente não é preciso fazer tal alteração, pois quase todos os canais fornecem qualidade quase que idênticas, visto que operam em frequências bem similares. Contudo, os problemas começam a aparecer quando você reside em um local onde há excesso de sinais wireless e aí um roteador começa a atrapalhar a transmissão do outro.

Modificando o canal da rede

Como solucionar? Para começar a resolver o problema é preciso identificar qual canal de rede seu roteador utiliza. Existem diversas formas para isso, mas recomendamos a utilização do programa inSSIDer. Detalhe: caso sua rede esteja funcionando bem, NÃO RECOMENDAMOS a modificação de quaisquer configurações!

Por que usar este aplicativo? Precisamos identificar o canal do roteador da sua residência e de outros que estejam chegando ao seu PC, por isso o inSSIDer é a ferramenta ideal para situação. Este software gratuito e muito simples de usar fornece diversas informações sobre quaisquer sinais wireless que estejam ao alcance da sua placa de rede.

Entre tantos detalhes é possível conferir o nome das redes (SSID), força do sinal, endereço físico (MAC), tipo de segurança (WAP ou WEP), velocidade teórica (54 Mbps é o comum para as redes do tipo 802.11g) e o canal utilizado pelo roteador em questão. Enfim, vamos instalar o programa para depois visualizar todos esses detalhes.

No Windows...

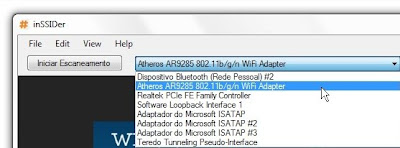

1) Você deve instalar o programa normalmente e então executá-lo.

2) Depois que aparecer a janela principal do programa, selecione a placa de rede sem fio.

Detalhe: normalmente a placa de rede contém o termo “wireless” (ou Wi-Fi) e traz uma sigla do tipo 802.11 e uma letra junto.

3) Depois de selecionar o dispositivo correto, basta clicar em “Iniciar Escaneamento”.

4) Os resultados são exibidos numa tabela e você deve identificar qual é o seu roteador.

5) É bom também reparar nos canais mais utilizados perto da sua casa. A grande maioria das pessoas não altera o canal do roteador e consequentemente todos acabam utilizando os canais 6, 1 ou 11 — que são os canais atribuídos por padrão pelas fabricantes de roteadores. Mais tarde precisaremos saber os canais que não são usados.

No seu navegador...

Agora você deve entrar na tela de configuração do seu roteador. Não sabe o endereço IP? Então vamos descobrir!

1) Para isso basta acessar o “Prompt de Comando” no Menu Iniciar e digitar:

ipconfig

2) O computador vai listar uma enormidade de informações, mas para nossa tarefa precisamos apenas do número do Gateway Padrão.

3) Para acessar o roteador é só abrir o navegador (qualquer um dos que você tiver instalado serve) e inserir o número do Gateway (algo como 192.168.2.1) na Barra de endereços.

Detalhe: nossa dica de hoje vamos detalhar dois modelos de roteadores muito famosos: um Belkin e outro D-Link.

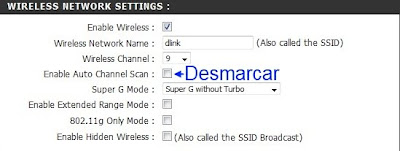

4) Na tela inicial deve haver algumas informações sobre o aparelho, mas a opção que precisamos modificar normalmente fica localizada em “Wireless Settings” (no caso do D-Link) ou em “Channel and SSD” (no Belkin).

Nota: possivelmente será solicitado o nome de usuário e senha para alterar as configurações, por isso é bom você conferir no manual do aparelho qual a senha padrão.

5) Antes de alterar o canal é importante conferir o modo de operação do modem. Caso seus aparelhos (notebook, computador, celular e outros) sejam compatíveis e utilizem apenas o padrão 802.11g, é melhor eliminar outros modos de operação (visto que eles podem atrapalhar a atuação principal do dispositivo).

6) Agora sim é hora de alterar o canal. Você pode escolher qualquer um, mas lembre-se da dica dada lá em cima: é melhor escolher um canal que não seja utilizado pela vizinhança. Ou então, escolha um que seja o oposto do que estão usando perto da sua casa.

Caso todos estejam configurados com os canais 1 e 6, opte pelo canal 9 por exemplo, que garante uma boa distância da frequência dos canais mais baixos. Detalhe: no roteador D-Link é preciso desmarcar a caixa “Enable Auto Channel Scan” (Habilitar procura automática de canal).

Atenção: caso seu modem esteja configurado com canal de extensão, deixe o canal padrão.

7) Clique em "Apply Changes" (Aplicar Modificações) e reinicie o roteador.

Nota: talvez seja necessário reconectar sua rede após a reinicialização, pois visto que o canal foi alterado o Windows pode perder a conexão.

Algumas dicas extras

A alteração do canal pode solucionar muitos problemas e aumentar a força do sinal, porém isso nem sempre resolve. Por isso resolvemos lembrar alguns pontos importantes que devem ser seguidos para que a rede seja mais estável e não gere tantos problemas:

*Posicione seu roteador em um local alto para abranger mais computadores ou o mantenha em um cômodo central da casa;

*Procure direcionar a antena de sua placa de rede de tal forma que a lateral dela fique apontando para o roteador;

*Se você utiliza os computadores da casa em uma sala única, prefira manter o roteador no mesmo local (isso aumenta a força do sinal);

*Caso seu roteador possua a opção “Hide SSID” (Ocultar SSID), ou “Enable Hidden Wireless” (Habilitar rede sem fio oculta), pode ser uma boa ideia ativá-las, visto que outros usuários não poderão se conectar à sua rede;

*Quem possui roteador compatível com a tecnologia 802.11n com certeza deve ativá-la, pois o alcance e a velocidade melhoram significativamente e

*E quem não tem um roteador deste tipo, talvez deva pensar na compra de um .

Enfim, nossas dicas acabam por aqui e desejamos boa sorte a todos que tiverem problemas com as redes wireless, pois as soluções nem sempre são tão claras, mas o Tecmosfera está continuamente lançando novas dicas para ajudá-los. Até mais!